使用ChatBox构建本地知识库

配置ChatBox

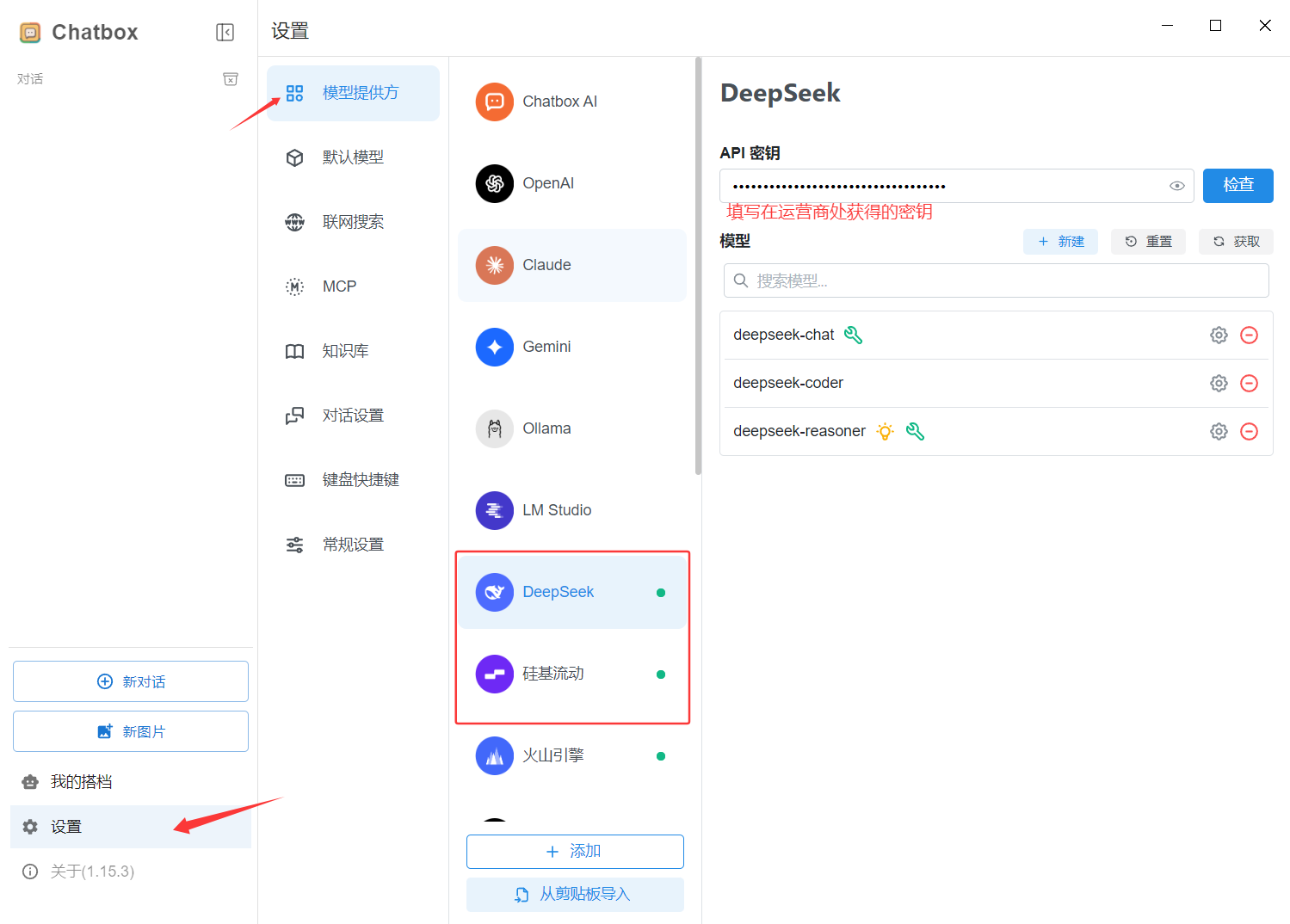

根据 使用ChatBox和AI对话 页面配置好ChatBox

内嵌向量化模型

构建知识库需要使用向量模型将文本转换成LLM模型可以识别的向量。

市面上的大部分教程都是推荐使用Ollama搭一个本地的LLM环境并拉取向量化模型实现该功能。但这几乎没法在一些配置较低的电脑上运行(或者运行很慢)。所以我们仍需要在网络上寻找模型运营商来解决这个问题。

由于DeepSeek官方并未提供内嵌向量化模型。所以需要去别的运营商那里寻找答案。

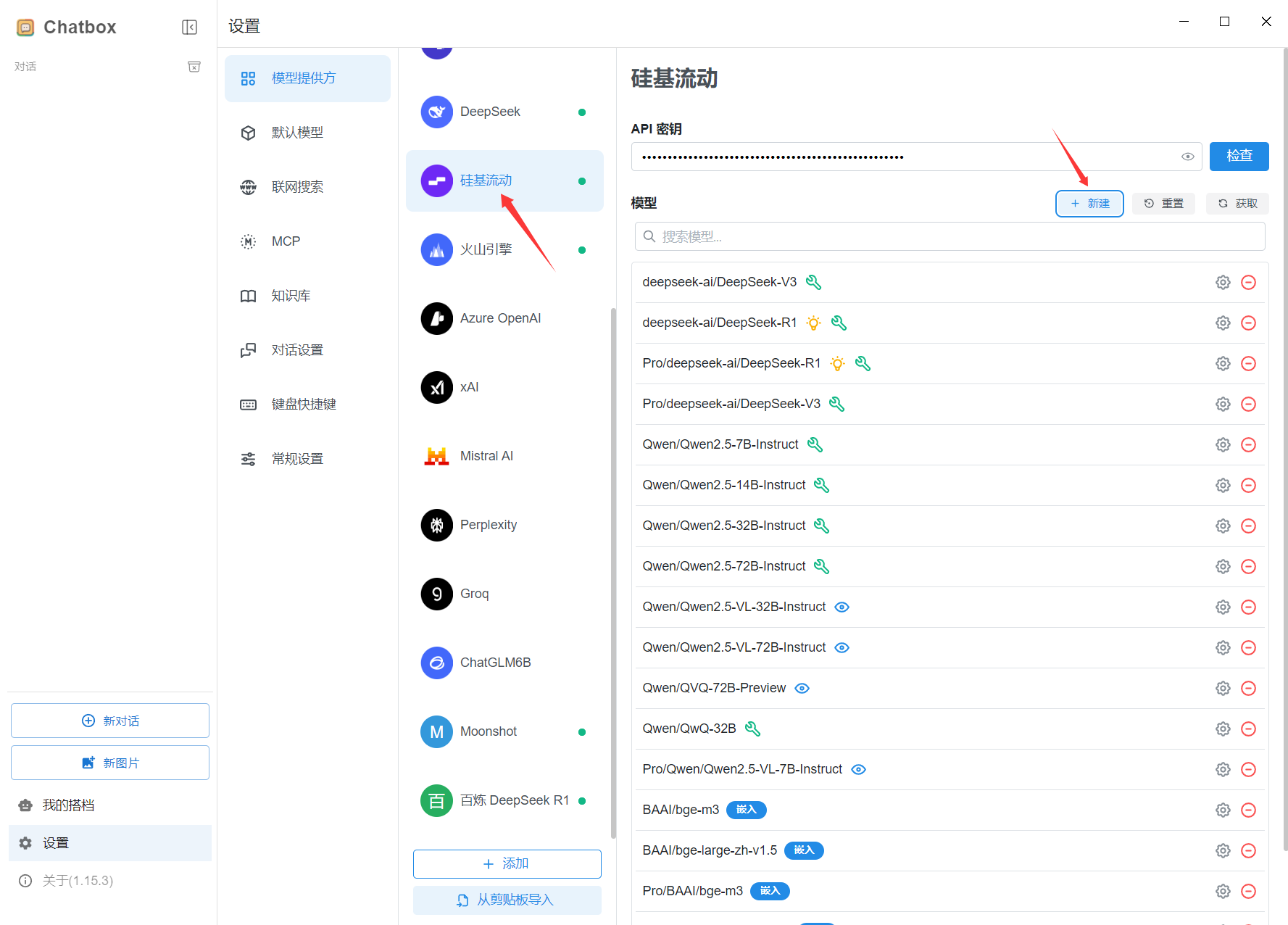

在搜索了各个运营商后,我发现硅基流动(SiliconFlow)公司提供的bge-m3模型符合需求,且该模型免费。

以下教程皆使用硅基流动的向量模型编写并测试通过。

获取硅基流动API Key

- 注册硅基流动账户: 硅基流动注册页面

- 然后应该会跳转到模型广场,如果没有跳转,则可以使用这个 链接

- 点击左侧

API密钥,与DeepSeek类似,我们需要在硅基流动中获取一个密钥。 - 在ChatBox中的设置的模型设置中选择硅基流动,填写获取的密钥

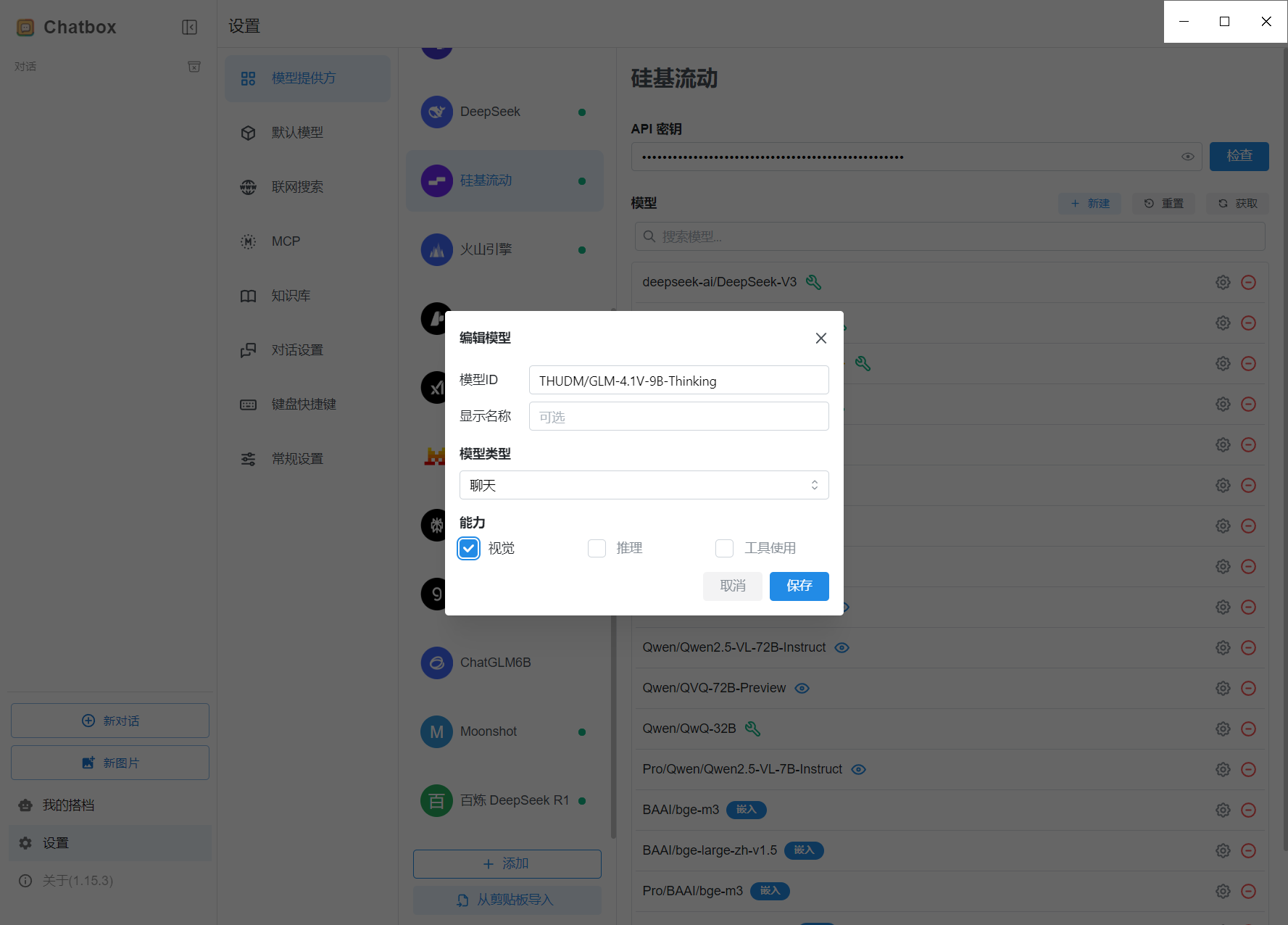

可选:设置视觉内嵌模型

- 点击模型的新建按钮,在弹出框中输入模型名称

THUDM/GLM-4.1V-9B-Thinking,这是一个免费的视觉向量模型 - 勾选能力中的视觉,保存。

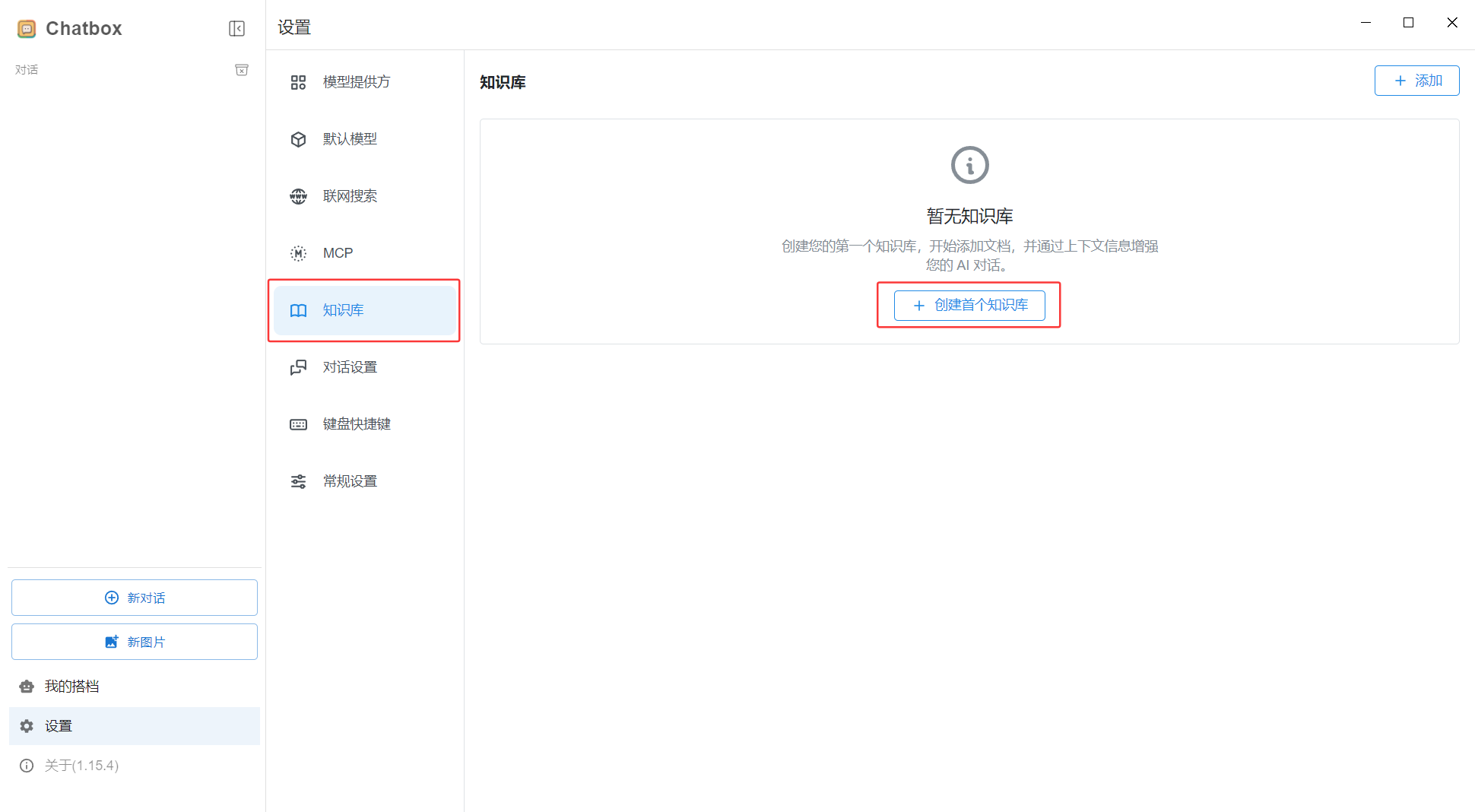

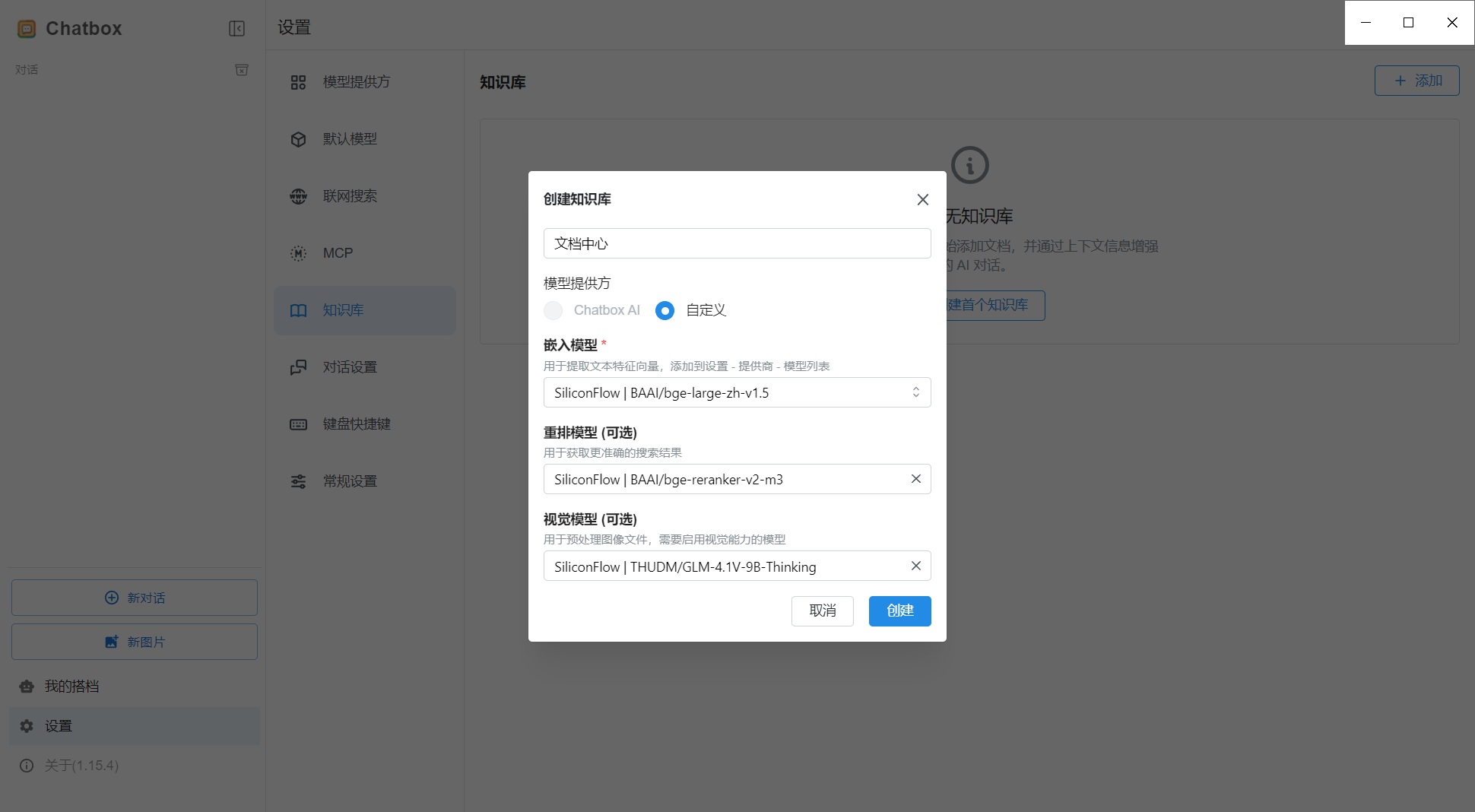

配置本地知识库

- 点击设置中的知识库

- 点击

创建首个知识库

- 设置知识库的名称、内嵌向量模型、重排模型、视觉模型(可选),点击创建

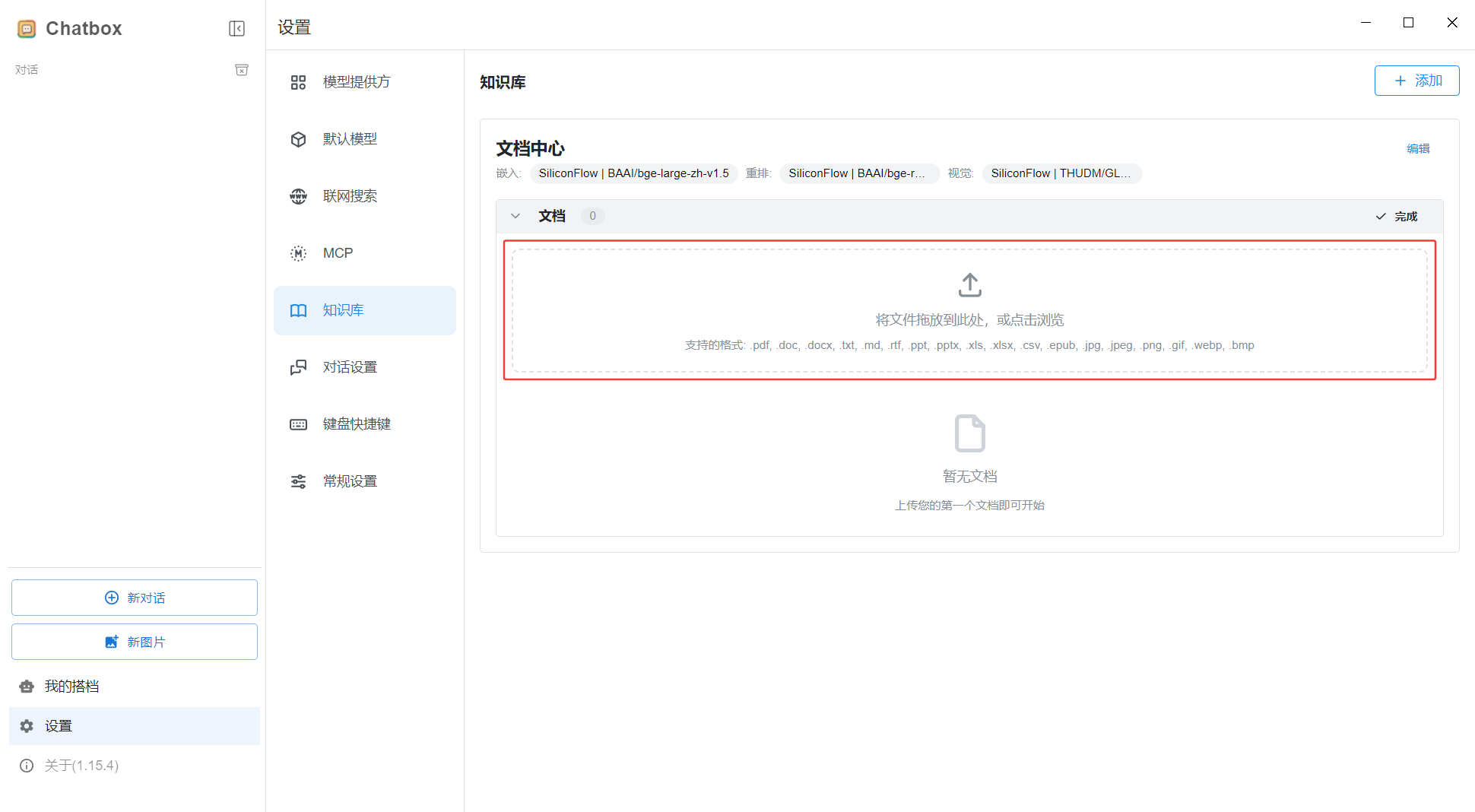

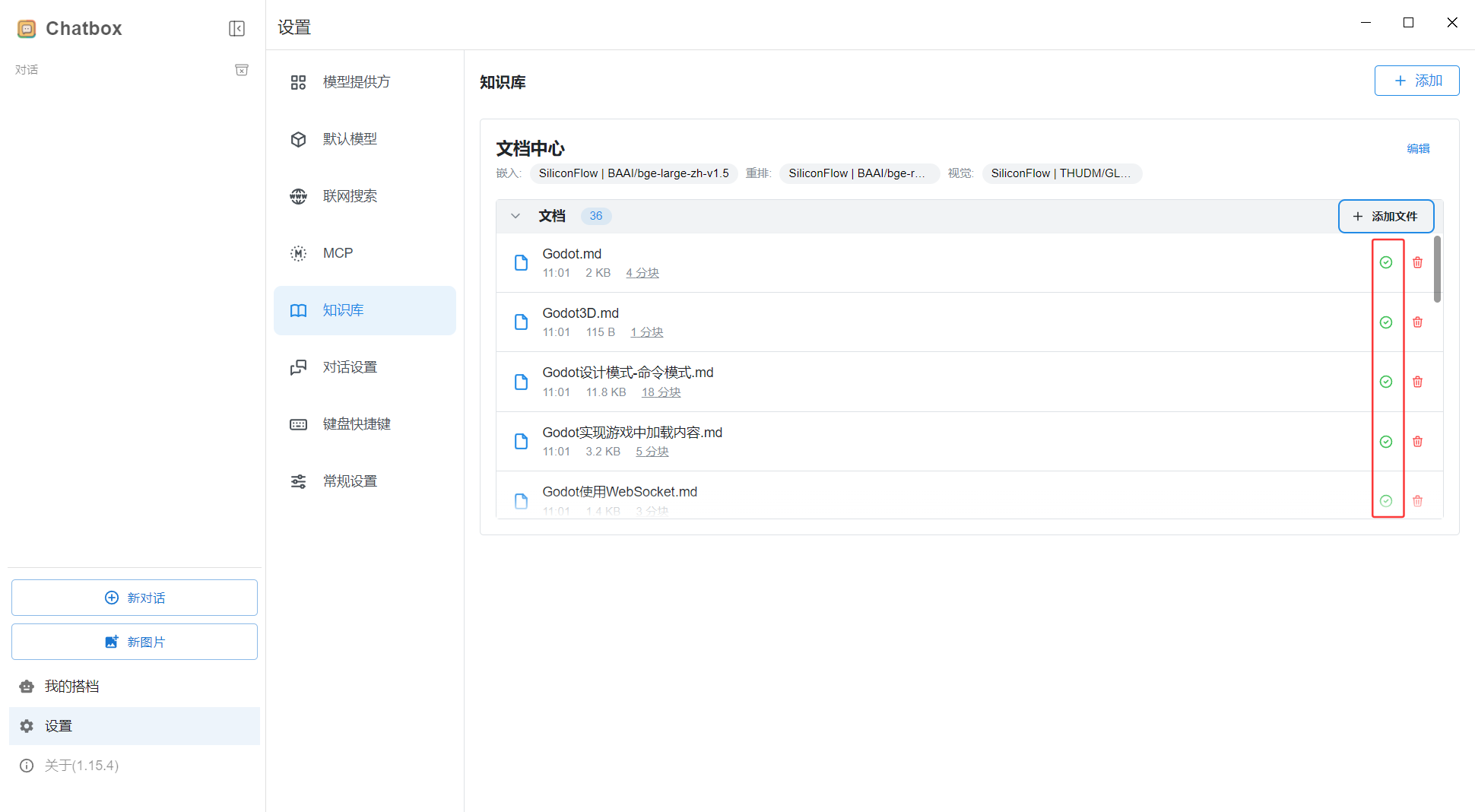

- 在创建好的知识库里点击上传文件,点击文本上传框或直接将文件拖入,即可开始上传。等待上传完成。

- 上传完成后,文件右侧会显示一个绿色上传成功图标,如果出现失败,可尝试重传,或检查模型配置。

- 藉此你已经完成了第一个本地知识库的创建。

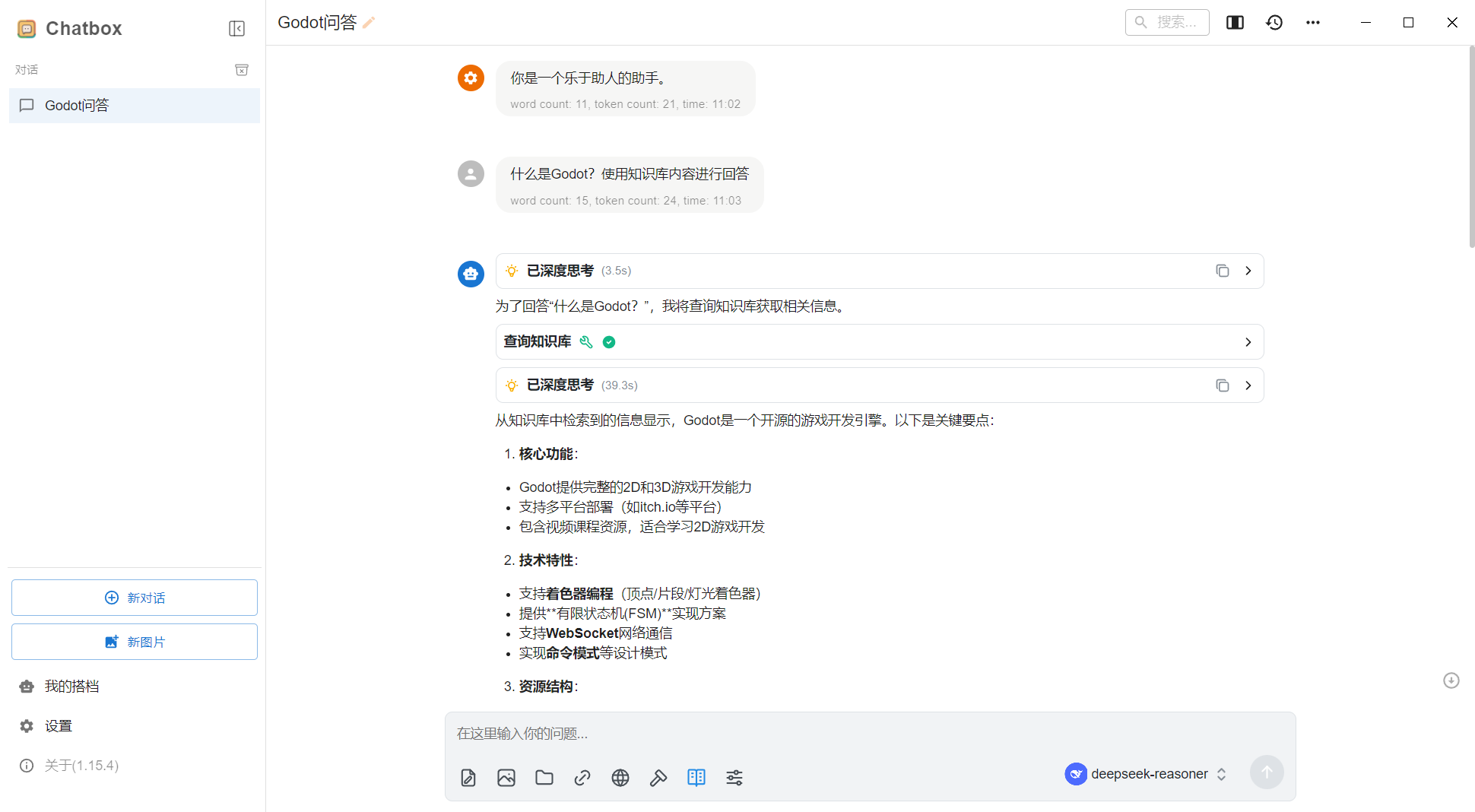

使用知识库对话

- 我在上一步将当前网站的独立游戏相关的文档添加进知识库中,以下使用这个知识库作为模型回答的依据。

- 点击新的对话。点击本地知识库按钮,选择刚完成配置的本地知识库。

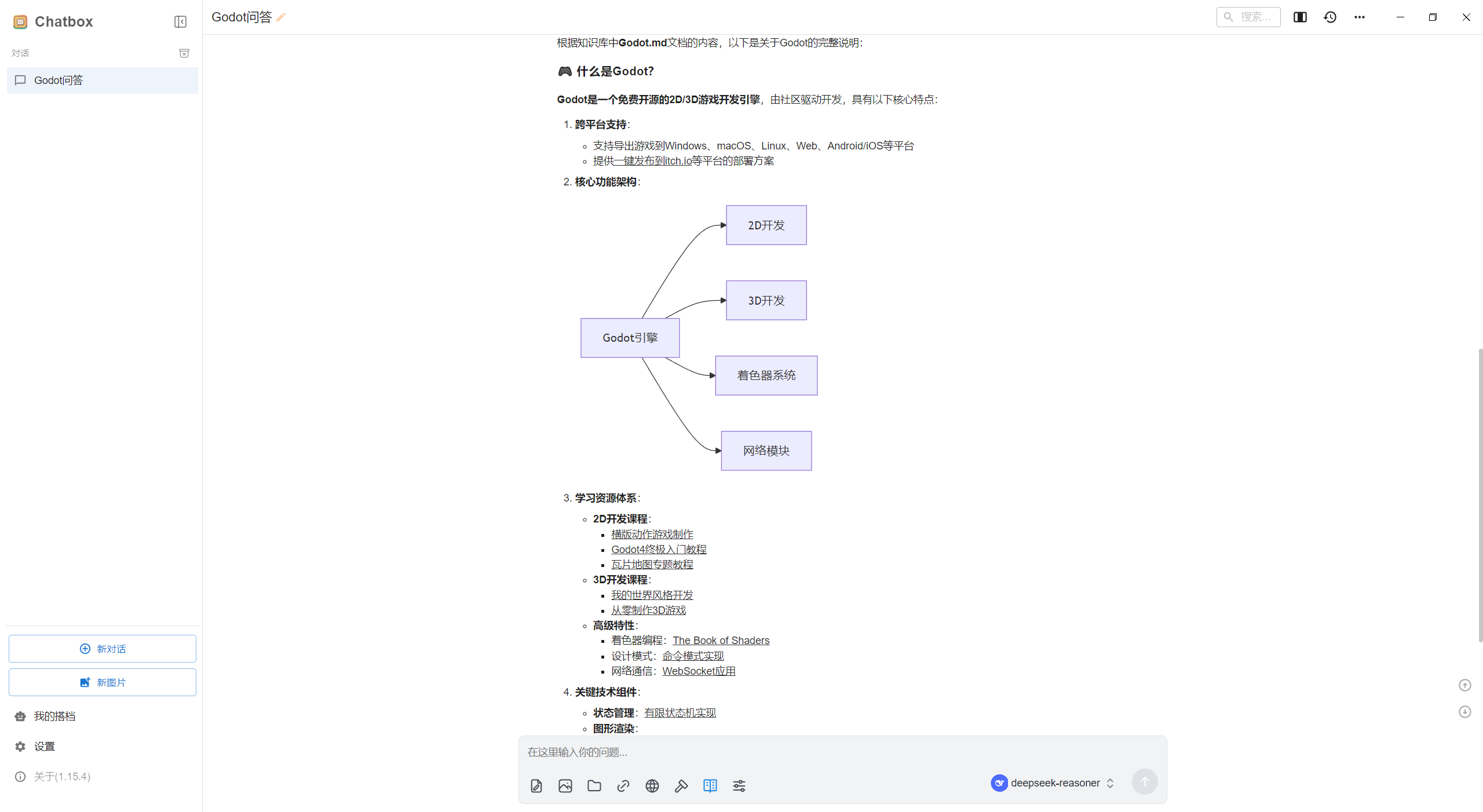

- 提问:

什么是Godot?使用知识库内容进行回答,ChatBox会调用DeepSeek回答问题,中途需要调用知识库时会自动请求知识库的内容。

- 成功根据博客内容作答。

京公网安备11010502055496号

京公网安备11010502055496号